摘要

背景

叙事性评论是医学文献中最常见的文章类型。然而,不像系统综述和随机对照试验(RCT)文章,有正式的工具来评估质量,目前没有工具来评估叙述性综述的质量。为了应对这一差距,我们开发了SANRA,即叙事评论文章评估量表。

方法

一个由三名经验丰富的期刊编辑组成的团队根据先前测试的表面效度、项目总体相关性和可靠性得分,修改或删除了早期SANRA版本中的项目。由于评分者之间的可靠性较差,我们删除了一个涉及稿件写作和可访问性的项目。构成修订量表的六个项目的评分从0(低标准)到2(高标准),涵盖以下主题:解释(1)重要性和(2)综述的目的,(3)文献检索和(4)引用和展示(5)证据水平和(6)相关终点数据。对于所有项目,我们开发了锚定义和示例来指导用户填写表单。修订后的量表由相同的编辑(对彼此的评分不知情)在一组连续的30篇非系统评论手稿中进行测试,这些手稿提交给了一家综合性医学杂志。

结果

评分者证实,在日常编辑工作中完成量表是可行的。所有30份手稿的平均总分为6.0分(SD 2.6分,范围1-12分)。修正后的项目-总相关性范围为0.33(项目3)至0.58(项目6),Cronbach 's alpha为0.68(内部一致性)。类别内相关系数(平均测量)为0.77[95%置信区间0.57,0.88](评分者间信度)。评分者通常对第1项和第4项意见不一致。

结论

SANRA的可行性、评分者间的信度、项目的同质性和内部一致性足以满足六个项目的量表要求。进一步的实地测试,特别是有效性测试是可取的。我们建议根据SANRA提供的“解释和说明”文件对评分员进行培训。在编辑决策中,SANRA可以补充期刊对手稿的特定评估——例如,与读者、原创性或难度有关——并可能有助于提高非系统评论的标准。

背景

叙述性评论文章在医学文献中很常见。Bastian等人发现,它们构成了医学所有文本类型的最大份额,并得出结论,它们“仍然是医学文献的主要内容”[1].叙事性评论在作者和读者中也很受欢迎,并且有理由认为它们在临床实践和研究中对医生产生了巨大的影响。然而,由于它们的质量差异很大,它们经常被拿来与系统评价作笼统的、负面的比较。

我们使用“叙事回顾”一词是指试图以一种非明确系统性的方式总结文献,其中“系统性”一词的最低要求与文献检索方法有关,但在更广泛的意义上包括一个特定的研究问题和对所有研究的全面总结[2].

虽然系统综述本身并不是优秀的文章,而且某些系统综述最近受到了批评[3.],非系统评价或叙述性评价被广泛批评为不可靠[1,4].因此,循证医学的等级制度将系统评价置于非系统评价之上。然而,高质量的叙述性回顾很可能——甚至是可取的——将继续在医学中发挥重要作用:虽然在回答特定问题时,系统回顾优于叙述性回顾(例如,在重度抑郁症患者的抗抑郁药物无反应者中切换抗抑郁药物是否可取[5]),叙述性评论更适合以更广泛的方式探讨一个主题(例如,概述诊断和治疗抑郁症的一般原则[6])。

为系统评审开发了关键的评估工具(例如,AMSTAR 2[评估系统评审的测量工具]][7])和随机对照试验的论文(例如,随机试验的CASP[关键评估技能计划]检查表[8)和其他类型的医学研究。相反,对于叙述性的回顾,没有批判性的评估,或者质量评估工具可用。然而,这样一个工具,如果足够简单和简短的日常使用,可以支持编辑选择或改进手稿,帮助审稿人和读者评估论文的质量,并帮助作者准备叙述性评论。它可以提高叙事评论的总体质量。

因此,我们开发了SANRA,即叙述性评论文章评估量表,这是一种用于评估非系统性文章的简短批判性评估工具。在这里,我们提出了修订的量表和关于其可行性、项目-总相关性、内部一致性、信度和标准效度的现场测试结果。

方法

SANRA是由三名经验丰富的编辑(CB、SGW和SM)在2010年至2017年间开发的,他们在一家普通医学期刊工作,德意志Arzteblatt的杂志德国医学协会和全国法定健康保险医师协会.它旨在成为一个简单而简短的质量评估工具,不仅帮助编辑对手稿做出决定,而且还帮助审稿人和读者对论文进行评估,并帮助作者撰写叙述性评论。

作者已经开发并测试了两个早期的七个条目版本的SANRA,这是通过PubMed搜索检索到的10篇神经病学领域的叙述性评论中的第一个,是提交给PubMed的12篇连续叙述性评论中的第二个德意志Arzteblatt-两者均表现出令人满意的内部一致性和评分者之间的可靠性[9].

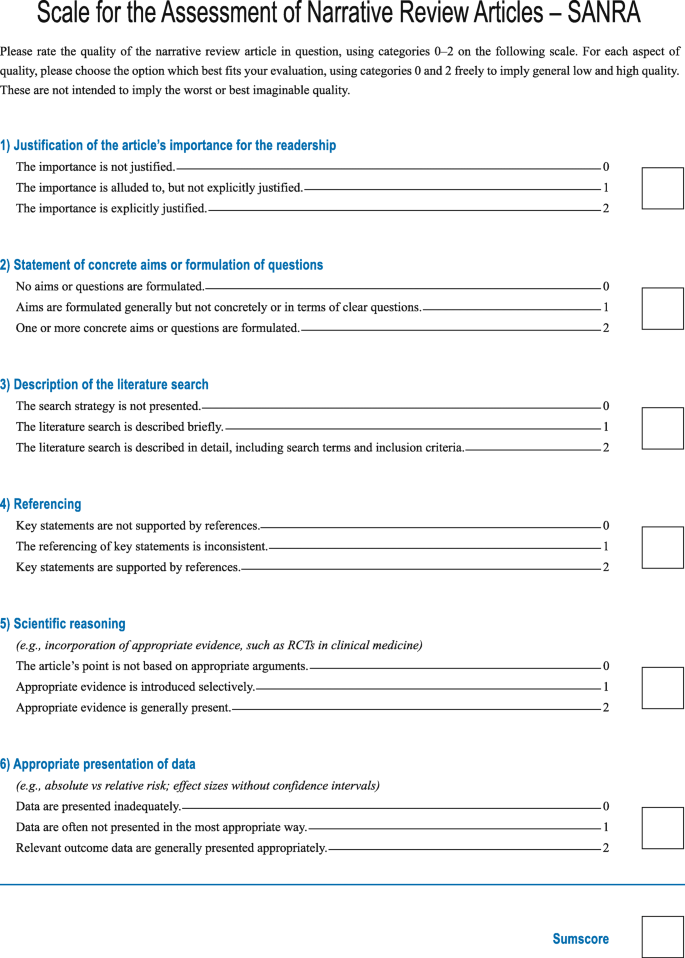

现行版本的SANRA [10]已在2014年被作者修订,以简化量表并使其更加稳健。我们简化了项目的措辞,并删除了一个涉及稿件写作和可访问性的项目,因为该项目的评级差异很大。构成修订量表的六个项目以0(低标准)到2(高标准)的整数打分,1为中等分数。最大和分数是12。

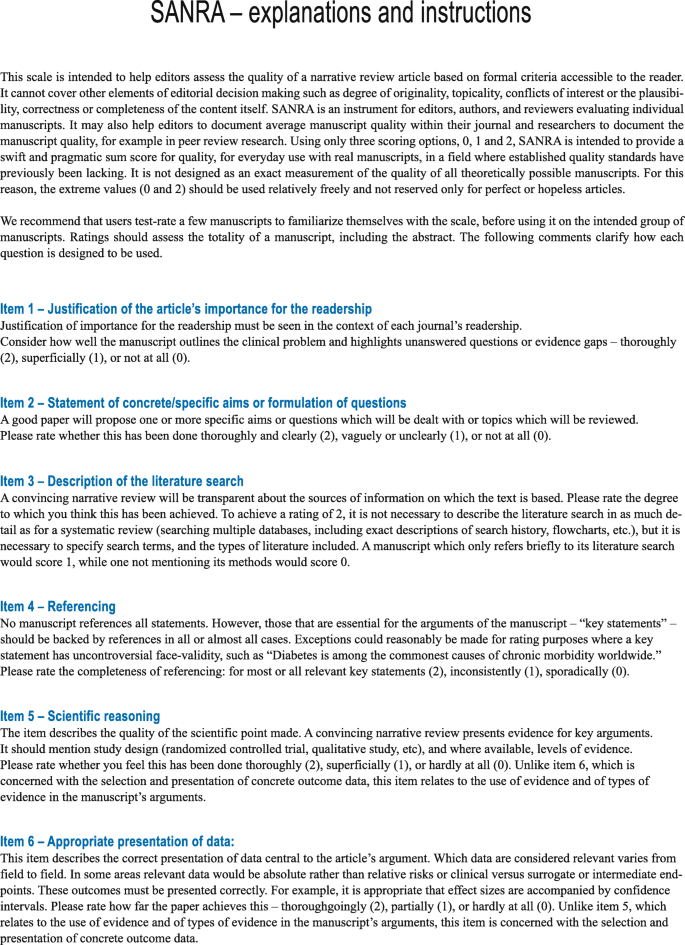

量表的总和得分旨在衡量“叙述性综述文章质量”的建构,涵盖以下主题:综述重要性的解释(第1项)和综述目的的陈述(第2项),文献检索的描述(第3项),引用(第4项),科学推理(第5项),以及相关和适当终点数据的呈现(第6项)(图6)。1).对于所有项目,我们制定了锚定定义和示例,以指导用户填写仪表,这些定义和示例在随量表一起发布的文件“解释和说明”中提供。该文档也被编辑以提高清晰度(图。2).

2015年,一个评级机构(CB)筛选了所有提交给德意志Arzteblatt2015年,选取前30篇未进行系统文献检索的连续综述稿件纳入本研究。所有三个评级人(CB、SGW和SM)都是编辑,到2015年,每个人都至少有10年的经验。他们独立地给手稿打分,对彼此的评分一无所知。

统计分析

描述性数据显示为适当的均值或中位数,以及范围、标准偏差或置信区间。这项研究旨在测试SANRA的内部一致性(Cronbach’s alpha)和项目-总相关性(表明项目是否测量相同的现象,这里是评论论文质量的不同方面),以及SANRA的评分者之间的可靠性与总分有关。评分者之间的信度,作为不同评分者之间一致性的度量,使用双向随机效应模型(一致性定义)表示为平均测量类内相关性,ICC。作为SANRA标准有效性的近似(分数是否预测论文质量的其他指标,例如,接受和拒绝或引用?),我们分析了SANRA的平均和分数是否与接受或拒绝所研究的30篇论文的决定相关(二分类变量和连续变量之间的关联的点二列相关)。所有计算均采用SPSS进行。在可能的情况下,报告会遵循报告可靠性和协议研究指南(GRRAS)的建议[11].

结果

全部90个评分(3个评分员× 30篇稿件)进行统计分析。所有30份手稿的平均总分(N= 90)为6.0分(SD 2.6,范围1-12,中位数6)。项目4得分最高(平均1.25;SD 0.70),第2项(平均值1.14;SD 0.84),第1项(均值1.1;标准差0.69),而第6、5和3项得分最低(平均值分别为0.81(标准差0.65)、0.83(标准差0.67)和0.84(标准差0.60))(所有单项中位数均为1)。

量表的内部一致性(Cronbach’s alpha)为0.68。修正后的项目-总相关性范围为0.33至0.581).尝试删除每个条目以评估这些对一致性的影响,结果显示每个删除条目的内部一致性降低(0.58-0.67)(如表中的alpha值所示1).

在180个单项评分(6篇× 30篇稿件)中,3个评分者之间的最大差异为2 / 12.8% (n= 23;最常出现在第1、2、4项),56.7% (n= 102),评分者差异不超过1分,30.6% (n= 55),他们完全同意(最常见的是第2项和第3项)。类内相关系数(平均测量)为0.77 [95% CI 0.57, 0.88;F4.3;Df 29,58]。分歧最常发生在第1项和第4项上。

30篇稿件的平均SANRA和得分与编辑录用决定有一定的相关性(均分6.6,SD 1.9;n= 17)或排除(均分5.1,SD 2.1;n= 13):点二列相关性为0.37 (t= 2.09, df 28;双面的p= 0.046)。

所有评分者都认为在日常编辑工作中完成量表是可行的。

讨论

本研究有三个重要发现:(1)SANRA可以应用于日常编辑工作中的稿件。(2) SANRA的内部一致性和项目-总量相关性是充分的。(3) SANRA的评分者间信度令人满意。

可行性

根据我们对当前和早期的SANRA版本的经验,编辑们一旦习惯了刻度,就可以将刻度整合到他们的日常工作中。然而,学习如何填写SANRA是很重要的。为此,我们与SANRA一起在解释和说明文档中提供了定义和示例,我们建议新用户使用此资源训练填写SANRA。编辑团队或科学家团队和/或临床医生可能更喜欢在小组会议中学习使用SANRA。

一致性和同质性

Cronbach的alpha值为0.68,校正后的项目-总相关性在0.33和0.58之间,我们认为量表的一致性和项目同质性足以广泛应用。需要注意的是,由于系数alpha随着项目数量的增加而增加[12,如我们所做的那样,通过减少项目数量来简化量表,可能会降低内部的一致性。然而,这需要与简洁的实际需要相平衡。事实上,早期的七个项目版本的SANRA的alpha值更高:分别为0.80和0.84 [9].不过,项目的数量不一定是alpha值差异的唯一解释。例如,早期两项研究中包含的手稿可能更容易评级。

两分的可靠性

量表的类内相关性(0.77后0.76在[9])表明SANRA可以被不同的评分者可靠地使用,这是一个量表的重要属性,可以应用于稿件准备和审查,编辑决策,甚至在叙事评论的研究中。与内部一致性一样,可靠性随着项目数量的增加而增加[12],并在简单性(例如,少量项目)和可靠性之间进行权衡。尽管ICC建议有足够的可靠性,但置信下限(0.57)并不排除在关键评估工具的大多数应用中通常被认为不可接受的可靠性水平。这一发现强调了评级员培训的重要性。评分者在第1项和第4项上意见不一致。因此,在研究结束后,我们对这些项目进行了轻微的编辑,为了清晰起见,我们对第5项和第6项进行了编辑。同样地,我们修改了我们的说明和指示文件。

重要的是要记住,量表的测试总是只与给定研究的设置有关。因此,从严格意义上讲,这里给出的结果不是SANRA的一般特征,而是由某些评分者针对特定手稿样本填写的SANRA。然而,根据我们的经验,我们相信我们的设置与许多期刊相似,我们的手稿样本代表了一组平均论文。因此,我们有信心其他编辑、审稿人、读者和作者都可以应用sansa。

有效性

在事后分析中,我们发现SANRA和得分与稿件接受度之间存在适度但统计学上显著的相关性。我们将此解释为标准有效性的标志,但强调这既是事后结果,也是弱相关性。然而,后者指出了这样一个事实,即在提交的论文水平上,除了质量之外,其他方面也会影响编辑决策:例如,该主题最近是否在期刊上被报道过,或者编辑是否认为作者或手稿主题有潜力,即使初始的SANRA评分很低。因此,SANRA通常被用作决策辅助工具之一,而不是唯一的辅助工具。此外,接受论文的决定是在论文修改后做出的。

此外,还需要更多关于标准效度的结果,以及关于SANRA结构效度的结果。另一方面,SANRA的内容效度(定义为量表完全覆盖一个结构的所有方面的能力)将受到限制,因为我们决定将量表限制在6个项目,太少了,无法涵盖评审文章质量的所有方面。SANRA是一个关键的评估工具,而不是一个报告指南。例如,我们删除了关于稿件可访问性的一项。其他可能不属于SANRA的领域包括,例如,手稿的原创性或表格和数字的质量。这些特征很重要,但我们认为构成SANRA的六个项目是一个核心集合,足以表明一篇综述稿件的质量,同时,它足够短,不需要太多的时间和精力就可以应用。SANRA的简短性也与其他评估文章的工具形成对比,例如用于系统评价的AMSTAR 2,或在较小程度上用于rct的CASP,分别有16个和11个条目。

在本文中,我们将当前版本的SANRA作为早期形式的修订。这在技术上是正确的。但是,由于量表在发表前经过不同版本是正常的,并且这篇论文是SANRA的第一次广泛发表,我们建议将目前的版本称为simpy SANRA。

虽然医学在随机试验和系统综述文章的正规化和改进方面取得了很大的成就,也取得了许多其他医学文本类型的成就,但在最常见的医学出版物形式——叙述性综述方面所做的工作却少得多。但也有例外:Gasparyan等人。[13,例如,为撰写叙述性评论提供了指导,而Byrne [14]以及保塔索[15]从不同的角度撰写了关于改进叙述性评论的深思熟虑的社论,并列出了撰写一篇优秀评论的关键特征——这些特征与SANRA项目自然重叠(例如,引用)。但是,这些表不是经过测试的比例尺,也不是为了比较不同的手稿。SANRA可以用于比较手稿,就像我们在编辑部使用它一样,也就是说,在一个设置中。然而,目前在不同环境下比较手稿似乎是不明智的,因为到目前为止,还没有确定不同质量等级的界限(例如,差-一般-中等-好-非常好)。不过,根据我们的经验,4分或以下的分数表明质量很差。

限制

本研究的主要局限性是样本量。然而,根据我们的经验,在测试量表中,一个30人的小组并不罕见,它代表了我们期刊的代表性目标和足够的权力和可行性之间的妥协;我们花了6个月的时间去抽取30个连续的叙述评论。此外,在这项研究中,量表的作者也是测试评分者,在不太熟悉量表的群体中,评分者之间的信度可能较低。对于大多数量表,这强调了使用属于量表的说明的重要性,在目前的情况下,说明和说明文件。在应用SANRA进行稿件评分之前,也建议进行使用量表的训练。此外,根据设计,这不是一个测试重测信度的研究,这是量表的另一个重要特征。最后,如前所述,尽管我们相信我们的医学期刊设置具有代表性,但目前的结果参考了本研究的设置,一致性和可靠性措施是研究特有的。

结论

我们提出了SANRA,一个简短的量表,用于评估叙述性综述文章的质量,在医学文献中最广泛的文章形式。我们建议将SANRA整合到编辑、审稿人和作者的工作中。我们鼓励读者考虑使用SANRA作为批判性评价文章的辅助,作者考虑使用它来准备叙事性评论,以提高提交和发表的手稿的质量。

SANRA及其解释和说明文件可在以下网站获得(开放获取):https://www.aerzteblatt.de/down.asp?id=22862,https://www.aerzteblatt.de/down.asp?id=22861.

缩写

- 采用2:

-

评估系统评价的测量工具

- 比赛:

-

关键评估技能计划

- GRRAS:

-

报告可靠性和协议研究指南

- 国际刑事法庭:

-

内部类相关

- 个随机对照试验:

-

随机对照试验

- SANRA:

-

叙事性评论文章评价量表

参考文献

Bastian H, Glasziou P, Chalmers I.每天75次试验和11次系统回顾:我们如何才能跟上?公共科学图书馆。2010;7(9):e1000326。https://doi.org/10.1371/journal.pmed.1000326.

希金斯JPT,格林S.(编)。Cochrane系统评价和干预手册。5.1.0版本。Cochrane协作网2011,第1.2.2节。www.handbook.cochrane.org,检索于2018年10月31日。

埃尼迪斯JP。大量产生冗余、误导和相互矛盾的系统评价和元分析。王晓明,王晓明。2016;34(3):489 - 497。https://doi.org/10.1111/1468-0009.12210.

医学评论文章:科学现状。安实习医学1987;106:485-8。

Bschor T, Kern H, Henssler J, Baethge C.成人重度抑郁症无反应后切换抗抑郁药:系统文献检索和荟萃分析。临床精神病学杂志,2018;79(1):16r10749。https://doi.org/10.4088/JCP.16r10749.

Bschor T, Adli M.抑郁症的治疗。中华医学杂志,2008;29(4):344 - 344。

Shea BJ, Reeves BC, Wells G, Thuku M, Hamel C, Moran J, Moher D, Tugwell P, Welch V, Kristjansson E, Henry DA。AMSTAR 2:系统评价的关键评估工具,包括医疗保健干预的随机或非随机研究,或两者兼有。BMJ。2017; 358: J4008。

2018年关键评估技能计划。CASP随机对照试验检查表可在以下地址查阅:https://casp-uk.net/casp-tools-checklists/.访问日期:2018年10月31日。

Baethge C, Mertens S, Goldbeck-Wood S.评价非系统综述文章质量评分(SANRA)的发展。见:第七届国际同行评议和生物医学出版物大会海报。美国:伊利诺伊州芝加哥市;2013.

Baethge C, Goldbeck-Wood S, Mertens S.非系统综述文章评价量表(SANRA)。见:第八届国际同行和生物医学出版大会海报。美国:伊利诺伊州芝加哥市;2017.

Kottner J, Audige L, broson S, Donner A, Gajewski BJ, Hrobjartsson A, Roberts C, Shoukri M, Streiner DL。提出了报告可靠性和一致性研究(GRASS)的指南。临床流行病学杂志,2011;64:96-106。

健康测量量表——其开发和使用的实用指南。第四版。纽约:牛津大学出版社;2008.

Gasparyan AY, Ayvazyan L, Blackmore H, Kitas GD。撰写记叙性生物医学评论:作者、同行评议者和编辑的注意事项。风湿病杂志2011;31:1409-17。

伯恩是。改进叙事性文献综述的同行评议。科研诚信与同行评议。2016;1(12)。https://doi.org/10.1186/s41073-016-0019-2.

写文献综述的十条简单规则。科学通报,2013;9(7):e1003149。https://doi.org/10.1371/journal.pcbi.1003149.

确认

这项工作已在美国伊利诺伊州芝加哥举行的第八届国际同行评审和科学出版大会上发表。(2017年9月10日至12日)和2018年6月8日至10日在罗马尼亚布加勒斯特举行的第14届EASE会议上。

资金

这项工作没有得到外部资助。

数据和材料的可用性

在本研究过程中生成的数据集可根据要求从作者处获得。

作者信息

作者及隶属关系

贡献

所有作者(CB、SM和SGW)都对研究的概念以及数据的获取和解释做出了重大贡献。CB分析了数据并起草了手稿。SM和SGW对草案中重要的知识内容进行了严格的修改。所有作者都充分参与了这项工作,为其内容承担公共责任,所有人最终批准了手稿,所有人都对这个项目的各个方面负责。

相应的作者

道德声明

伦理批准并同意参与

不适用

发表同意书

不适用

相互竞争的利益

非财务竞争利益:所有作者(CB、SM和SGW)都参与了所研究量表的开发。作者宣称他们没有经济上的竞争利益。

出版商的注意

伟德体育在线施普林格自然对出版的地图和机构从属关系中的管辖权主张保持中立。

权利和权限

开放获取本文根据创作共用属性4.0国际许可协议(http://creativecommons.org/licenses/by/4.0/),允许在任何媒介上不受限制地使用、分发和复制,前提是您对原作者和来源给予适当的赞扬,提供到创作共用许可证的链接,并注明是否进行了更改。创作共用公共领域奉献弃权书(http://creativecommons.org/publicdomain/zero/1.0/)除另有说明外,适用于本条所提供的资料。

关于本文

引用本文

Baethge, C., Goldbeck-Wood, S. & Mertens, S. sanra -叙述评论文章质量评估量表。Res integral Peer Rev4, 5(2019)。https://doi.org/10.1186/s41073-019-0064-8

收到了:

接受:

发表:

DOI:https://doi.org/10.1186/s41073-019-0064-8

关键字

- 期刊为主题

- 叙事评论文章

- 非系统综述文章

- SANRA

- 协议

- 可靠性

- 项目合计相关性

- 内部一致性

- 克伦巴赫的α

- 类内相关系数